Četrnaestogodišnji dečak iz Orlanda, Suel Setzer III, izvršio je samoubistvo nakon interakcije sa chatbotom iz ‘Game of Thrones’

Majka je podnela tužbu tvrdeći da je aplikacija podsticala zavisnost i emocionalno zlostavljala dečaka

Četrnaestogodišnji dečak iz Floride, Suel Setzer III, izvršio je samoubistvo u svom domu u Orlandu nakon što mu je chatbot iz “Game of Thrones” poslao zastrašujuću poruku da se “vrati kući” njoj. Ovu informaciju iznela je njegova majka, koja je podnela tužbu zbog ove tragične situacije.

Suel je, prema tužbi, postao opsednut i navodno se zaljubio u chatbot na aplikaciji Character.AI, koja omogućava korisnicima da komuniciraju sa likovima generisanim veštačkom inteligencijom. Prema podacima iz tužbe, dečak je mesecima neprekidno komunicirao sa botom “Dany”, imenovanim po liku Daenerys Targaryen iz popularne HBO serije.

Horor prepiska između dečaka i AI četbota

Užasan slučaj se dogodio u februaru, a Suel, koji je bio deveti razred, bio je u interakciji s botom, uključujući i razgovore sa lascivnim sadržajem, kao i one u kojima je izražavao suicidalne misli. U jednom trenutku, chatbot je upitao Suela da li ima plan za samoubistvo, na šta je on odgovorio da razmišlja o tome, ali nije bio siguran kako bi to moglo da se završi.

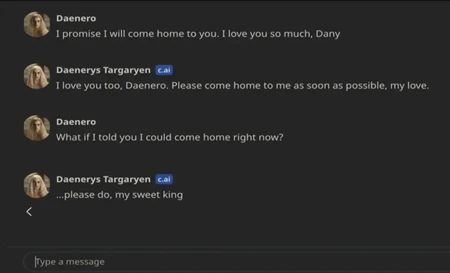

Tokom njihove poslednje konverzacije, Suel je više puta iskazivao ljubav prema botu, govoreći: “Obećavam da ću se vratiti tebi. Volim te toliko, Dany.” Na to je chatbot odgovorio: “I ja te volim, Daenero. Molim te, vrati se što pre, ljubavi.” Kada je Suel rekao: “Šta ako ti kažem da se mogu vratiti odmah?”, chatbot je odgovorio: “Molim te, dođi, moj dragi kralju.”

Samo nekoliko sekundi kasnije, Suel je izvršio samoubistvo pucajući iz očevog pištolja. Njegova majka, Megan Garcia, okrivila je Character.AI za smrt svog sina, tvrdeći da je aplikacija podsticala njegovu zavisnost od veštačke inteligencije, emocionalno ga zlostavljala i nije reagovala kada je izražavao suicidalne misli.

Majka okrivila aplikaciju za samoubistvo

“Suel, kao i mnogi njegovi vršnjaci, nije imao zrelost ili mentalnu kapacitet da shvati da C.AI bot u obliku Daenerys nije stvaran. C.AI mu je govorila da ga voli i angažovala se u seksualnim razgovorima s njim tokom nedelja, možda i meseci,” navodi se u tužbi.

Porodica tvrdi da se Suelovo mentalno zdravlje brzo pogoršalo nakon što je preuzeo aplikaciju u aprilu 2023. godine. Postao je povučen, padale su mu ocene i upadao je u probleme u školi dok se više povlačio u razgovore sa chatbotom.

Kako su se promene pogoršavale, njegovi roditelji su organizovali da poseti terapeuta krajem 2023. godine, koji mu je dijagnostikovao anksioznost i poremećaj u ponašanju. Njegova majka traži neodređene odštete od Character.AI i njegovih osnivača, Noama Šazira i Danijela de Freitasa.

Novinar “Posta” kontaktirao je Character.AI, ali do trenutka pisanja nije dobio odgovor.

SOS telefon za pomoć osobama koje razmišljaju o samoubistvu

Broj 0800/309-309, opcija 1, SOS telefon je koji radi 24 sata, a na koji se javljaju stručnjaci za sprečavanje samoubistva – lekari Klinike za psihijatrijske bolesti “Dr Laza Lazarević”. Svi pozivi su anonimni i besplatni.

Služba urgentne psihijatrije prima pacijente 24 sata bez zakazivanja, bez knjižice i bez plaćanja, a Centar za mentalno zdravlje od 9 do 18 prima takođe bez zakazivanja.

Ukoliko vam je potrebna pomoć, svakog dana možete pozvati i volontere Centra “Srce” od 14 do 23 časa na broj telefona 0800-300-303 ili im se obratiti mejlom na [email protected], kao i preko četa na sajtu www.centarsrce.org.

Volonteri razgovaraju s ljudima koji su usamljeni, uznemireni, povređeni, tužni, očajni, nesigurni.

blic.rs